Runway 发布了新一代动作捕捉模型 Act-Two。相比前代 Act-One,Act-Two 在动作保真度、一致性和流畅度上有显著提升。

该模型只需一个驱动表演视频(例如用手机拍摄的演员表演)和一个参考角色图像或视频,即可生成动画,而无需专业设备如动作捕捉服或工作室。

- 支持全身跟踪:头部、面部表情、上半身、手部和背景。

- 只需一个“表演驱动视频”与一个“参考角色”即可进行动画生成。

- 可将表演转换为多种不同风格、艺术方向和环境下的角色动画,而不会影响表演质量。

目前仅开放给企业和合作方,预计很快全面开放。

- 改进的保真度和一致性:相比 Act-One,Act-Two 在角色动画的细节上大幅提升,包括微妙的面部表情、肢体动作和手指跟踪,避免了以往的模糊或不一致问题。

- 多功能适用性:可以应用于各种角色类型(如人类、卡通、动物或虚构生物),并适应不同环境、艺术风格(如写实、动画或抽象)和艺术方向,而不牺牲表演的原汁原味。

- 输入输出:输入一个最长 30 秒的表演视频(包含语音、表情和手势),输出高质量动画视频。支持唇同步、复杂动作捕捉,并可用于 AI 视频生成中的精确控制。

- 应用场景:适合动画制作、AI 电影、播客、社交媒体视频、VTuber 或游戏开发,能快速将真人表演转化为 AI 角色动画,极大降低制作门槛。

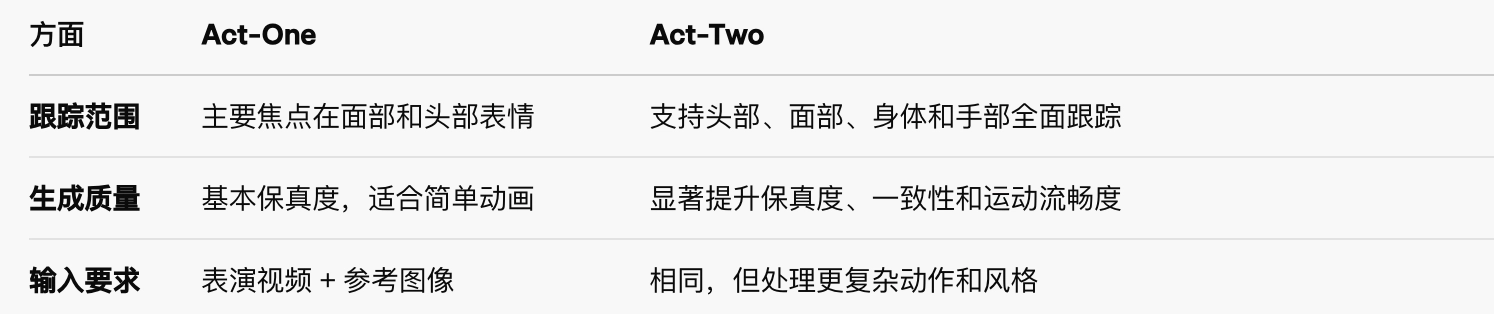

Act-One 与 Act-Two 的比较

使用方式

- 准备材料:拍摄一段表演视频(包含语音和动作),并上传参考角色图像。

- 生成动画:在 Runway 平台上选择 Act-Two 模型,输入提示(如风格描述),系统自动处理。

- 输出:生成视频后,可进一步编辑或扩展。用户测试显示,它在处理快速动作或复杂表情时表现出色,但偶尔需多次迭代以优化细节(如某些舌头动作可能被简化)。